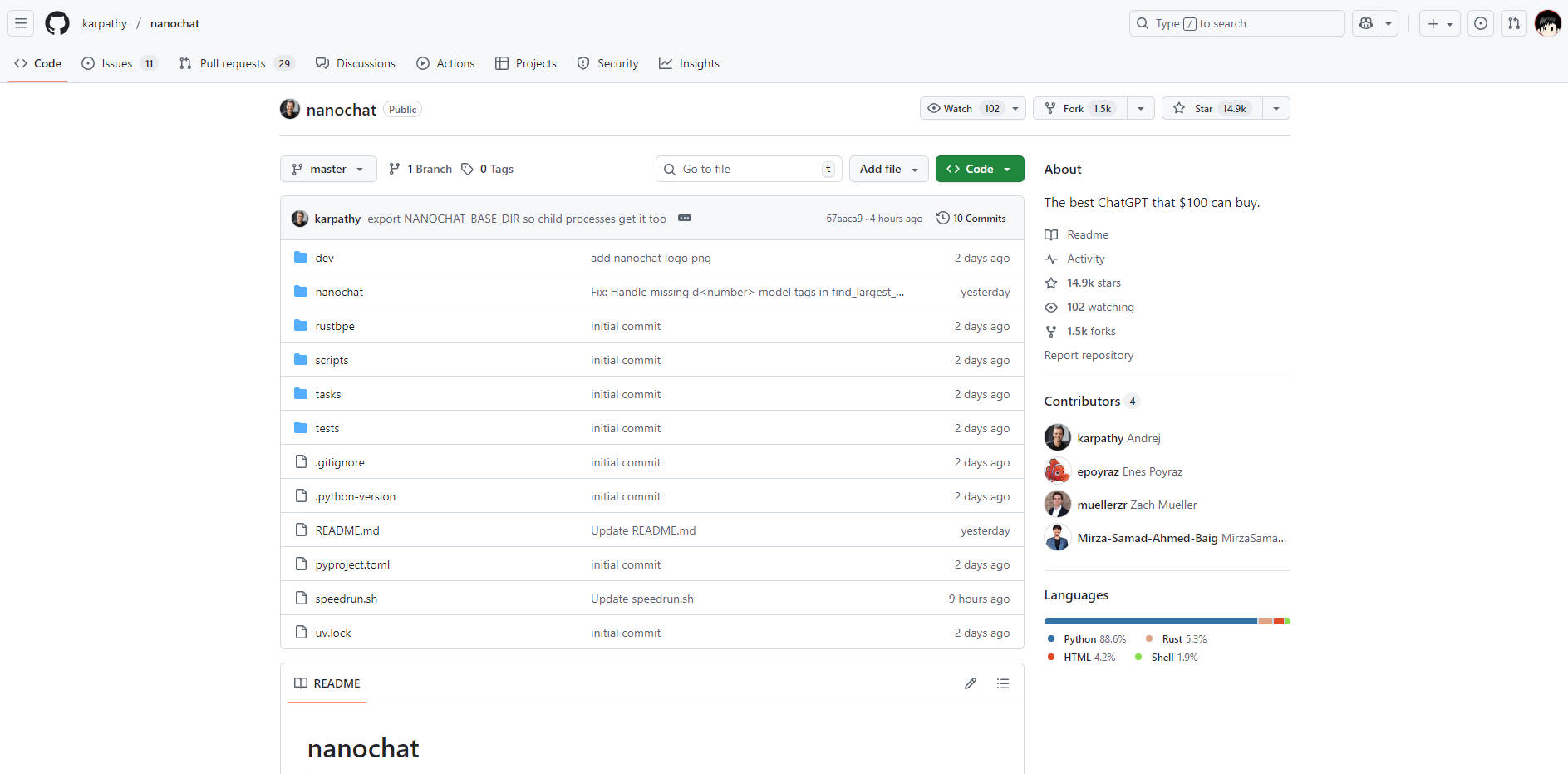

What is nanochat?

nanochatは、開発者や研究者向けに設計された、モダンな大規模言語モデル(LLM)の完全かつ最小限で、非常にアクセスしやすい実装です。これは、トークン化から機能的なウェブUIまで、パイプライン全体を約1000行のクリーンでハッキング可能なコードにまとめることで、LLM開発に通常伴う複雑さと法外なコストの問題を解決します。エンドツーエンドで独自のモデルを構築・実行することでLLMスタックを習得したいと考えるすべての人にとって、nanochatは比類のない学習およびプロトタイピング環境を提供します。

Key Features

nanochatは、包括的な理解とアクセシビリティを追求して設計されており、コンパクトな専用システム上でLLMライフサイクルのあらゆる段階を制御することを可能にします。

🛠️ End-to-End Pipeline Integration

重要なコンポーネントを抽象化するフレームワークとは異なり、nanochatはトークン化、事前学習、ファインチューニング、評価、推論、そしてシンプルなウェブインターフェースまでをカバーするフルスタック実装を提供します。この統合された設計により、単一の自動化スクリプト(speedrun.sh)を使用して全プロセスを実行でき、即座に検証可能な結果が得られます。

💡 Minimal, Hackable Codebase

実装全体は、約1000行の依存関係の少ないコードベース(Python、Rust、HTML、およびShellを使用)に収められています。この最小限のアーキテクチャは、認知負荷を大幅に軽減し、開発者が大規模な設定オブジェクトや複雑なファクトリパターンに惑わされることなく、システムのあらゆるコンポーネントを読み、理解し、変更することを可能にします。

💰 Affordable Single-Node Deployment

単一の8XH100ノード上で、1000ドル未満でLLMの完全な学習と展開を実現します。例えば、 $100 tier モデルは、約4時間で学習および推論が可能であり、大規模なLLM実験を現実的な予算でアクセス可能にします。この効率性は、綿密なリソース管理と合理化されたコードによって達成されており、数百万ドル規模の設備投資を必要としません。

📈 Scalable Performance Tiers

デフォルトのspeedrunでは概念実証のための基礎モデル(約4e19 FLOPs)を提供していますが、nanochatはスケーラブルな構造を持っています。開発者は、モデルの深さなどのいくつかのパラメータを調整し、デバイスバッチサイズを介してメモリを管理するだけで、より大きく高性能なモデル(GPT-2 COREスコアをわずかに上回る約300ドルのティアなど)に移行できます。

Use Cases

nanochatは、理論的な知識を目に見える、実行可能なモデルへと変換するように設計されており、教育と迅速な開発の両方に理想的です。

1. Mastering the LLM Stack

ブラックボックスなAPIコールを超えて、大規模言語モデルの仕組みを真に理解したいと考える開発者にとって、nanochatはまさに実験室となるでしょう。フルパイプラインスクリプトを実行することで、生のデータから会話型ウェブUIに至るまでのトレーニングプロセス全体を目の当たりにし、その根底にある原理やアルゴリズムを深く実践的に習得することが可能です。

2. Rapid Prototyping and Iteration

最小限のコードベースを活用して、モデルアーキテクチャ、最適化手法、あるいは斬新なファインチューニング方法への変更を迅速にテストできます。スタック全体が単一ノードで完結し、簡単に実行できるため、LLM分野における新しいアイデアを検証するために必要な通常の開発サイクル時間を大幅に短縮できます。

3. Building Highly Specialized Micro-Models

nanochatの効率性を活用し、特定のドメインタスクや社内アプリケーションに特化したカスタムの小規模モデルを作成できます。フルトレーニングおよびファインチューニングパイプラインを費用対効果高く実行できる能力は、組織が大規模で専用の機械学習インフラに投資することなく、独自のマイクロモデルを開発することを可能にします。

Unique Advantages

nanochatの価値提案は、完全性、アクセスしやすさ、コスト効率という独自のバランスにあり、過度に複雑なLLMフレームワークに対する明確な代替手段を提供します。

比類のない認知的アクセシビリティ: 意図的に最小限のコードベースに焦点を当てることで、複雑で迷路のような設定オブジェクトや「if-then-elseの怪物」は存在しません。このコードは、読みやすく、一貫性があり、最大限にフォーク可能な「強力なベースライン」として設計されており、開発者がシステム全体を完全に理解するために必要な時間を大幅に削減します。

検証可能なメトリクスと評価: すべての実行において、詳細な評価メトリクス(例:ARC-Challenge、MMLU、GSM8Kスコア)を含む包括的な

report.mdファイルが生成されます。測定可能な結果へのこのコミットメントは、変更やトレーニング実行のパフォーマンスと影響を科学的に追跡できることを保証します。実践を通じた学習のために設計: LLM101nの集大成プロジェクトとして、nanochatは本質的に教育ツールとして設計されています。これは、現代のLLM開発の複雑さを、達成可能で実行可能なプロジェクトへと凝縮し、学習曲線がセットアップの不満ではなく、得られる知識において急峻であることを保証します。

Conclusion

nanochatは、開発者が大規模言語モデルの真の理解と実装の習得を達成するための、直接的かつ強力な道筋を提供します。手頃な予算でスタック全体を実行することで、LLM作成のあらゆる段階に対する深い洞察が得られます。

今すぐnanochatのリポジトリを探索し、予算内で構築できる最高のChatGPTクローンを作り始めましょう。