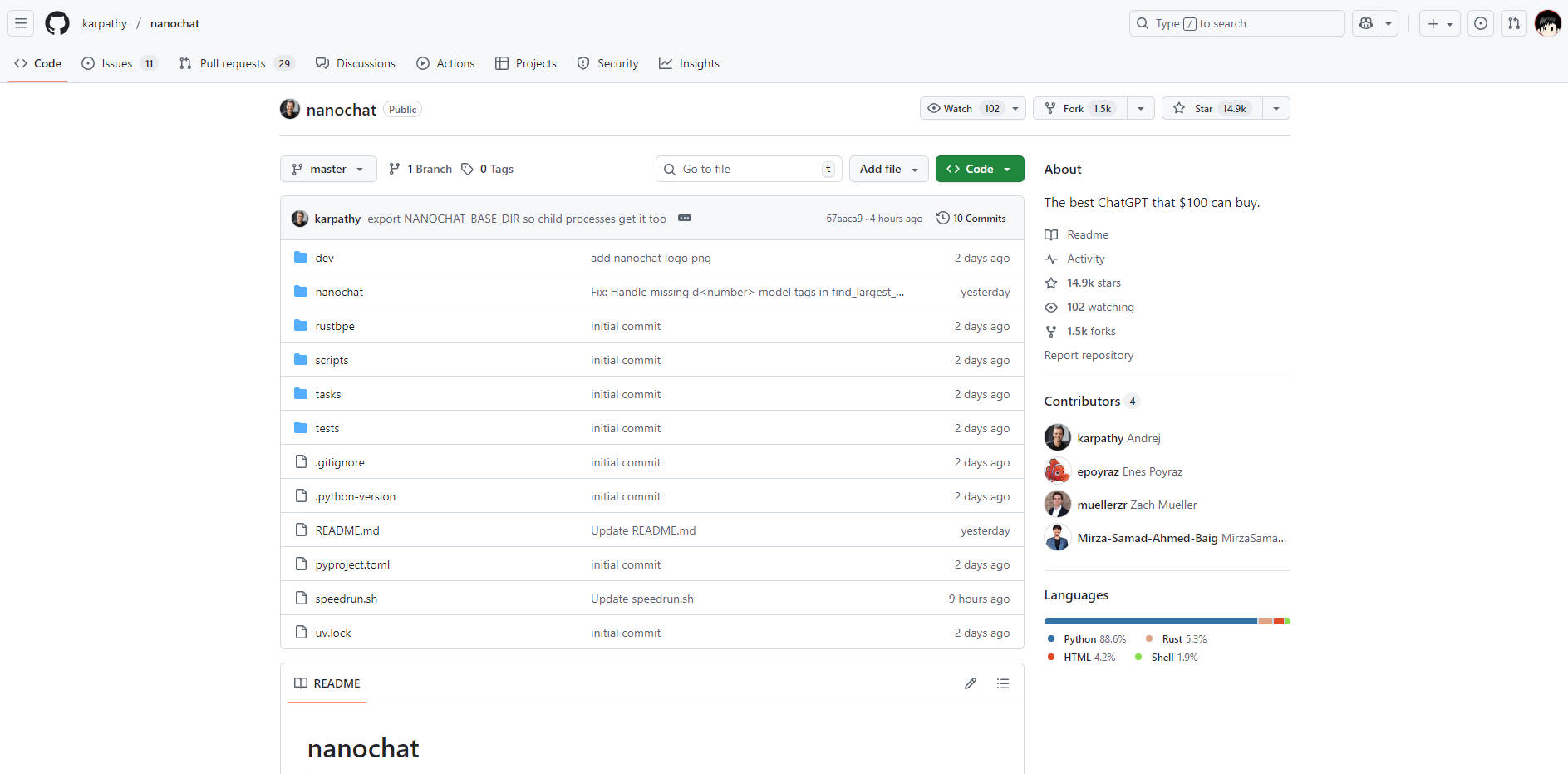

What is nanochat?

nanochat 是一个为开发者和研究人员设计的、完整、精简且高度易用的现代大型语言模型(LLM)实现。它通过将从词元化到功能性网页用户界面(Web UI)的整个流程打包成大约1000行整洁、易于修改的代码,解决了LLM开发通常伴随的复杂性和高昂成本。对于任何希望通过端到端地构建和运行自己的模型来掌握LLM技术栈的人来说,nanochat 提供了一个无与伦比的学习和原型开发环境。

主要特点

nanochat 旨在实现全面的理解和高度的易用性,使您能够在紧凑、专用的系统上掌控LLM生命周期的每个阶段。

🛠️ 端到端流程整合

不同于那些抽象掉关键组件的框架,nanochat 提供了一个全栈实现,涵盖了词元化、预训练、微调、评估、推理以及一个简洁的网页界面。这种一体化设计确保您可以通过一个自动化脚本(speedrun.sh)执行整个过程,提供即时、可验证的结果。

💡 精简、可修改的代码库

整个实现包含在一个大约1000行的轻量级代码库中(采用 Python、Rust、HTML 和 Shell 语言)。这种精简的架构显著降低了认知负担,让开发者无需面对庞大的配置对象或复杂的工厂模式,即可阅读、理解和修改系统的每个组件。

💰 经济实惠的单节点部署

在单个8XH100节点上以不到1000美元的成本完成完整的LLM训练和部署。例如,$100 tier 模型在大约四小时内即可完成训练和推理,使得大规模LLM实验在实用预算内变得可行。这种效率得益于精心资源管理和精简的代码,避免了数百万美元的资本支出。

📈 可扩展的性能层级

虽然默认的 speedrun 提供了一个用于概念验证的基础模型(约4e19 FLOPs),但 nanochat 的架构设计可扩展。开发者只需通过调整模型深度、通过设备批次大小管理内存等几个参数,即可切换到更大、能力更强的模型(例如约300美元档次,其性能略微超越 GPT-2 CORE 得分)。

应用场景

nanochat 旨在将理论知识转化为可执行的实际模型,使其非常适合教育和快速开发。

1. 掌握LLM技术栈

如果您是一位希望超越黑盒API调用、真正理解大型语言模型工作机制的开发者,那么 nanochat 就是您的实验室。通过运行完整的流程脚本,您将亲眼见证整个训练过程——从原始数据到会话式网页用户界面——从而深入、实践地掌握其底层原理和算法。

2. 快速原型开发与迭代

利用精简的代码库,快速测试模型架构修改、优化技术或新颖的微调方法。由于整个技术栈被封装且易于在单个节点上运行,您可以大幅缩短LLM领域新想法验证所需的典型开发周期时间。

3. 构建高度专业化的微型模型

利用 nanochat 的高效率,创建针对特定领域任务或内部应用程序的定制化小型模型。经济高效地运行完整的训练和微调流程的能力,使组织无需投入大量专用机器学习基础设施即可开发专有的微型模型。

独特优势

nanochat 的价值主张在于其在完整性、易用性和成本效益方面的独特平衡,为过于复杂的LLM框架提供了一个明确的替代方案。

无与伦比的认知易用性: 有意专注于精简代码库意味着没有复杂、迷宫般的配置对象或“if-then-else 巨兽”。代码被设计成一个“强大的基线”,它可读、内聚且最大限度可分叉,大幅缩短了开发者全面理解系统所需的时间。

可验证的指标和评估: 每次运行都会生成一个全面的

report.md文件,其中包含详细的评估指标(例如 ARC-Challenge、MMLU、GSM8K 得分)。这种对可衡量结果的承诺确保您能够科学地跟踪您的修改和训练运行的性能及影响。专为实践学习而设计: 作为 LLM101n 的毕业设计项目,nanochat 从根本上被设计为一款教育工具。它将现代LLM开发的复杂性提炼成一个可实现、可运行的项目,确保学习曲线陡峭在于知识的获取,而非设置的挫败。

总结

nanochat 为开发者提供了一条直接而强大的途径,以实现对大型语言模型的真正理解和实施精通。通过以可承受的预算运行整个技术栈,您将深入了解LLM创建的每个阶段。

立即探索 nanochat 代码库,开始构建您预算范围内能买到的最佳 ChatGPT 克隆。