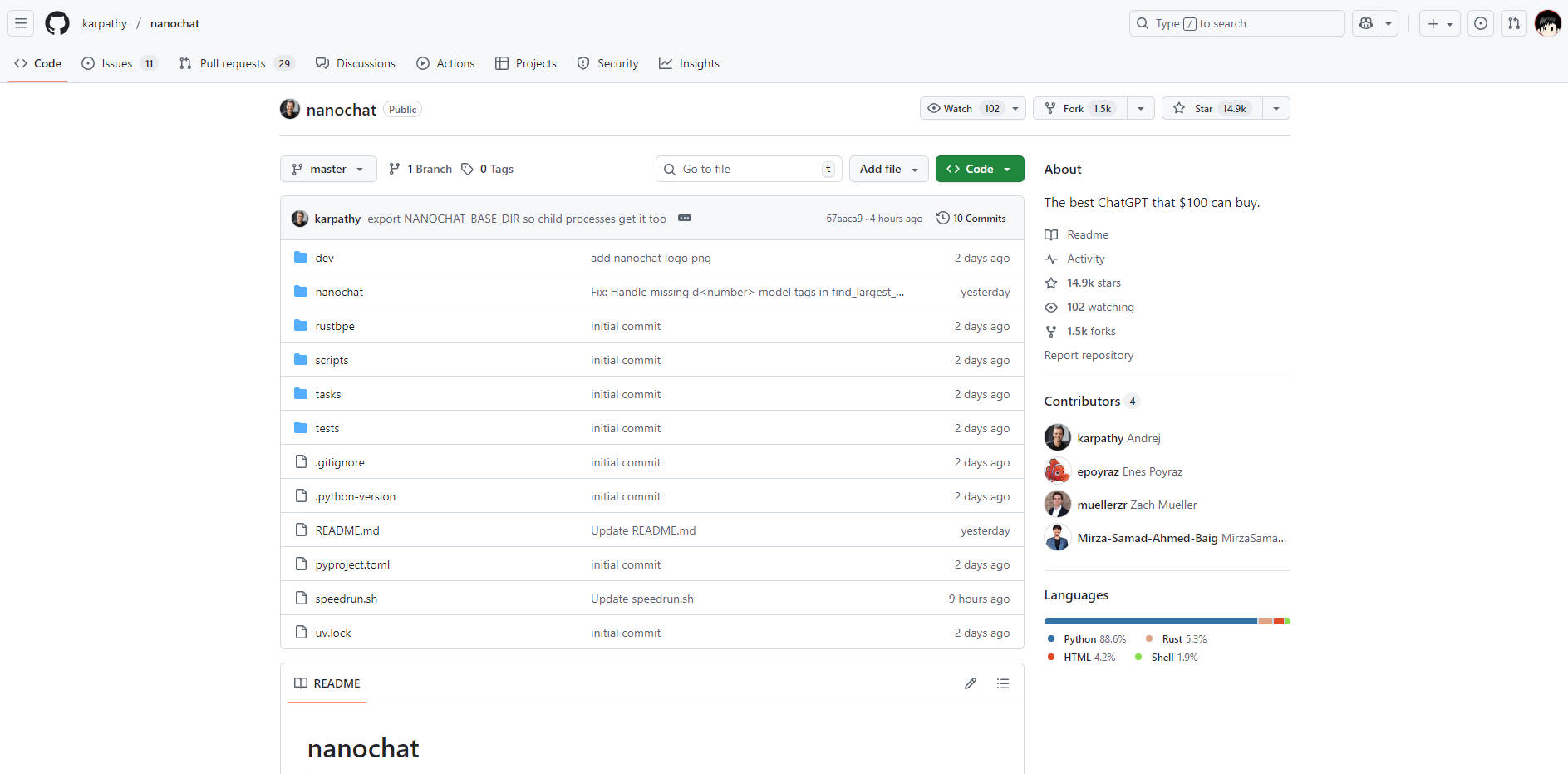

What is nanochat?

nanochat은 개발자와 연구자를 위해 설계된, 완전하고 간결하며 접근성이 매우 뛰어난 최신 대규모 언어 모델(LLM) 구현체입니다. 토큰화부터 기능적인 웹 UI에 이르는 전체 파이프라인을 약 1000줄의 깔끔하고 수정 가능한 코드 안에 통합함으로써, LLM 개발과 관련된 복잡성과 엄청난 비용 문제를 해결합니다. 자신만의 모델을 엔드투엔드로 구축하고 실행하여 LLM 스택을 완벽하게 마스터하고자 하는 모든 사람에게 nanochat은 비할 데 없는 학습 및 프로토타이핑 환경을 제공합니다.

주요 기능

nanochat은 포괄적인 이해와 접근성을 위해 설계되었으며, 이를 통해 작고 전용 시스템에서 LLM 라이프사이클의 모든 단계를 제어할 수 있습니다.

🛠️ 엔드투엔드 파이프라인 통합

핵심 구성 요소를 추상화하는 프레임워크와 달리, nanochat은 토큰화, 사전 학습, 미세 조정, 평가, 추론, 그리고 간단한 웹 인터페이스를 포함하는 풀 스택 구현을 제공합니다. 이러한 응집력 있는 설계 덕분에 단일 자동화 스크립트(speedrun.sh)를 사용하여 전체 프로세스를 실행할 수 있으며, 즉각적이고 검증 가능한 결과를 얻을 수 있습니다.

💡 최소한의, 수정 가능한 코드베이스

전체 구현은 약 1000줄의 가벼운 코드베이스(Python, Rust, HTML, Shell 활용)에 담겨 있습니다. 이러한 최소한의 아키텍처는 인지 부하를 획기적으로 낮춰, 개발자들이 방대한 설정 객체나 복잡한 팩토리 패턴을 탐색할 필요 없이 시스템의 모든 구성 요소를 읽고, 이해하고, 수정할 수 있도록 해줍니다.

💰 합리적인 단일 노드 배포

단일 8XH100 노드에서 1000달러 미만으로 전체 LLM 학습 및 배포를 달성할 수 있습니다. 예를 들어, $100 tier 모델은 약 4시간 만에 학습 및 추론이 가능하며, 이는 대규모 LLM 실험을 현실적인 예산으로 접근 가능하게 합니다. 이러한 효율성은 신중한 자원 관리와 간소화된 코드를 통해 달성되며, 수백만 달러에 달하는 자본 지출의 필요성을 없애줍니다.

📈 확장 가능한 성능 계층

기본 speedrun이 개념 증명을 위한 기본 모델(~4e19 FLOPs)을 제공하지만, nanochat은 확장성을 염두에 두고 설계되었습니다. 개발자들은 모델 깊이와 같은 몇 가지 매개변수를 조정하고 장치 배치 크기를 통해 메모리를 관리함으로써 더 크고 성능이 뛰어난 모델(예: GPT-2 CORE 점수를 약간 능가하는 ~$300 tier)로 쉽게 전환할 수 있습니다.

활용 사례

nanochat은 이론적 지식을 실제 실행 가능한 모델로 전환하도록 설계되어 교육과 신속한 개발 모두에 이상적입니다.

1. LLM 스택 마스터하기

블랙박스 API 호출을 넘어 대규모 언어 모델의 작동 원리를 진정으로 이해하고자 하는 개발자라면, nanochat이 바로 여러분의 연구실입니다. 전체 파이프라인 스크립트를 실행함으로써, 원시 데이터부터 대화형 웹 UI에 이르는 전체 학습 과정을 직접 경험하게 되며, 이는 근본적인 원리와 알고리즘에 대한 깊이 있는 실습적 숙달을 가능하게 합니다.

2. 신속한 프로토타이핑 및 반복

최소한의 코드베이스를 활용하여 모델 아키텍처, 최적화 기법, 또는 새로운 미세 조정 방법에 대한 수정을 신속하게 테스트할 수 있습니다. 전체 스택이 하나의 노드에 포함되어 쉽게 실행 가능하므로, LLM 분야에서 새로운 아이디어를 검증하는 데 필요한 일반적인 개발 주기 시간을 획기적으로 단축할 수 있습니다.

3. 고도로 전문화된 마이크로 모델 구축

nanochat의 효율성을 활용하여 특정 도메인 작업이나 내부 애플리케이션에 맞춰진 맞춤형의 소규모 모델을 생성하세요. 전체 학습 및 미세 조정 파이프라인을 비용 효율적으로 실행할 수 있는 능력은 조직이 광범위하고 전용적인 머신러닝 인프라에 투자하지 않고도 독점적인 마이크로 모델을 개발할 수 있도록 합니다.

차별화된 강점

nanochat의 가치 제안은 완전성, 접근성, 그리고 비용 효율성의 독특한 균형에 있으며, 이는 지나치게 복잡한 LLM 프레임워크에 대한 명확한 대안을 제시합니다.

비교할 수 없는 인지적 접근성: 최소한의 코드베이스에 의도적으로 초점을 맞춘다는 것은 복잡하고 미로 같은 구성 객체나 "if-then-else 몬스터"가 없다는 것을 의미합니다. 이 코드는 가독성, 응집성, 그리고 최대의 포크 가능성을 갖춘 "강력한 기준점"으로 설계되어, 개발자가 전체 시스템을 완전히 이해하는 데 필요한 시간을 획기적으로 줄여줍니다.

검증 가능한 지표 및 평가: 모든 실행은 상세한 평가 지표(예: ARC-Challenge, MMLU, GSM8K 점수)를 포함하는 포괄적인

report.md파일을 생성합니다. 측정 가능한 결과에 대한 이러한 약속은 수정 사항 및 학습 실행의 성능과 영향을 과학적으로 추적할 수 있도록 보장합니다.실습을 통한 학습에 최적화: LLM101n의 최종 프로젝트로서 nanochat은 근본적으로 교육 도구로 설계되었습니다. 이는 현대 LLM 개발의 복잡성을 달성 가능하고 실행 가능한 프로젝트로 정제하여, 학습 곡선이 설정의 어려움이 아닌 습득된 지식에서 가파르게 되도록 보장합니다.

결론

nanochat은 개발자들이 대규모 언어 모델에 대한 진정한 이해와 구현 숙달을 달성할 수 있는 직접적이고 강력한 길을 제공합니다. 합리적인 예산으로 전체 스택을 실행함으로써, LLM 생성의 모든 단계에 대한 깊이 있는 통찰력을 얻을 수 있습니다.

오늘 nanochat 저장소를 탐색하고, 예산으로 구현할 수 있는 최고의 ChatGPT 클론을 구축해 보세요.