What is LiveBench?

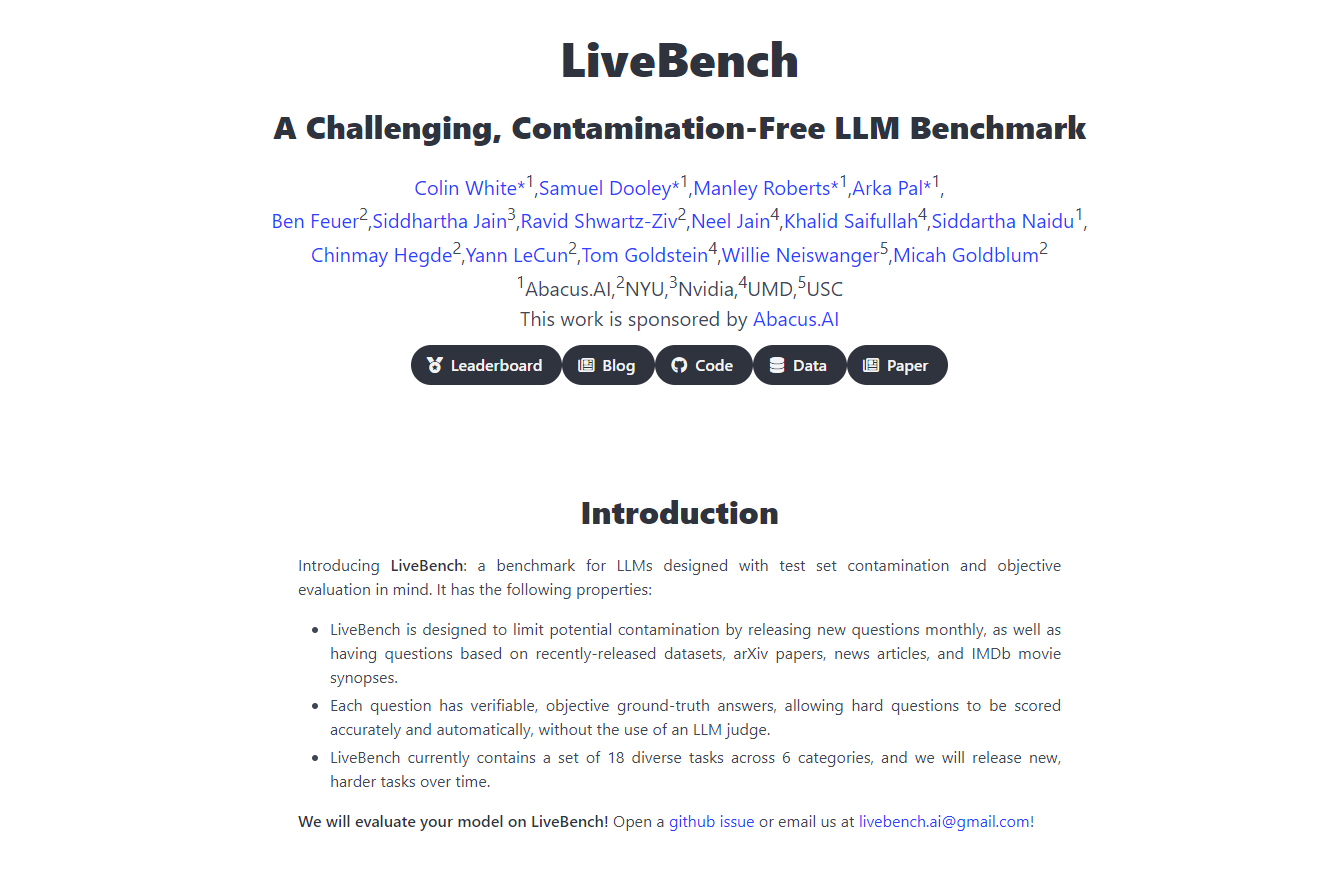

Presentamos LiveBench AI, una plataforma revolucionaria de evaluación comparativa creada en colaboración con Yann LeCunn y su equipo, diseñada para desafiar y evaluar modelos de lenguaje grandes (LLM) como nunca antes. Este punto de referencia actualizado continuamente presenta nuevos desafíos que los modelos no pueden simplemente memorizar, lo que garantiza evaluaciones precisas e imparciales. Evalúa los LLM en diversas dimensiones, incluyendo razonamiento, programación, escritura y análisis de datos, proporcionando un marco de evaluación sólido, justo y completo que es crucial para el desarrollo y la implementación de la IA.

Características principales

Actualizaciones continuas: LiveBench introduce nuevas preguntas mensualmente, basadas en conjuntos de datos recientes, artículos de arXiv, artículos de noticias y resúmenes de IMDb, evitando la memorización y asegurando una evaluación continua de las capacidades de LLM.

Puntuación objetiva: Cada pregunta tiene una respuesta verificable y objetiva, lo que permite una puntuación precisa y automatizada sin la necesidad de jueces de LLM, manteniendo así la equidad en la evaluación.

Rango de tareas diverso: Actualmente abarca 18 tareas diferentes en 6 categorías, con nuevas tareas más difíciles que se lanzarán con el tiempo para mantener el punto de referencia desafiante y relevante.

Diseño anticontaminación: LiveBench está estructurado para incluir solo preguntas con respuestas claras y objetivas, minimizando el sesgo y asegurando la integridad de la evaluación.

Evitar las trampas de evaluación: La plataforma está desarrollada para evitar las trampas de los métodos tradicionales de evaluación de LLM, como los sesgos en las respuestas a preguntas difíciles, centrándose en la corrección objetiva y verificable.

Casos de uso

Investigación y desarrollo de IA: Los investigadores pueden usar LiveBench para evaluar con precisión el rendimiento de sus LLM frente a un conjunto dinámico de desafíos, impulsando mejoras e innovaciones en la IA.

Evaluación comparativa de empresas tecnológicas: Las empresas de tecnología pueden emplear LiveBench para comparar la efectividad de diferentes LLM, guiando las decisiones sobre qué modelos integrar en sus productos y servicios.

Evaluación educativa: Los educadores pueden utilizar la plataforma para enseñar y evaluar a los estudiantes sobre las capacidades y limitaciones de los LLM, proporcionando información práctica sobre la evaluación y el desarrollo de la IA.

Conclusión

LiveBench AI se encuentra a la vanguardia de la evaluación comparativa de la IA, ofreciendo una herramienta de evaluación completa, justa y en constante evolución para los modelos de lenguaje grandes. Su enfoque innovador garantiza que el desarrollo de LLM esté basado en desafíos del mundo real, lo que lleva a tecnologías de IA más robustas y confiables. Descubra el verdadero potencial de la IA con LiveBench AI, donde se prueba y se demuestra el futuro de la IA.

Preguntas frecuentes

¿Qué hace que LiveBench sea único en comparación con otros puntos de referencia de IA? A diferencia de otros puntos de referencia, LiveBench utiliza un conjunto dinámico de desafíos con respuestas claras y objetivas, actualizadas mensualmente para evitar la memorización, lo que garantiza una evaluación continua y precisa de las capacidades de LLM.

¿Cómo garantiza LiveBench la equidad de sus evaluaciones? LiveBench evita los sesgos y problemas de equidad centrándose en preguntas con respuestas verificables y objetivas y sin depender de jueces de LLM para la puntuación, lo que mantiene un proceso de evaluación imparcial.

¿Se puede utilizar LiveBench para fines educativos? Absolutamente. LiveBench proporciona un conjunto de datos práctico y desafíos del mundo real que pueden ser utilizados por los educadores para enseñar y evaluar a los estudiantes sobre la evaluación de la IA, convirtiéndolo en un recurso educativo invaluable.

More information on LiveBench

Top 5 Countries

Traffic Sources

LiveBench Alternativas

Más Alternativas-

WildBench es una herramienta de evaluación avanzada que evalúa los LLM en un conjunto diverso de tareas del mundo real. Es esencial para aquellos que buscan mejorar el rendimiento de la IA y comprender las limitaciones del modelo en escenarios prácticos.

-

BenchLLM: Evalúe las respuestas de LLM, cree conjuntos de pruebas, automatice las evaluaciones. Mejore los sistemas impulsados por IA con evaluaciones de rendimiento integrales.

-

Lanza productos de IA más rápido con evaluaciones LLM sin código. Compara más de 180 modelos, crea prompts y prueba con confianza.

-

Las empresas de todos los tamaños utilizan Confident AI para justificar por qué su LLM merece estar en producción.

-