What is LiveBench?

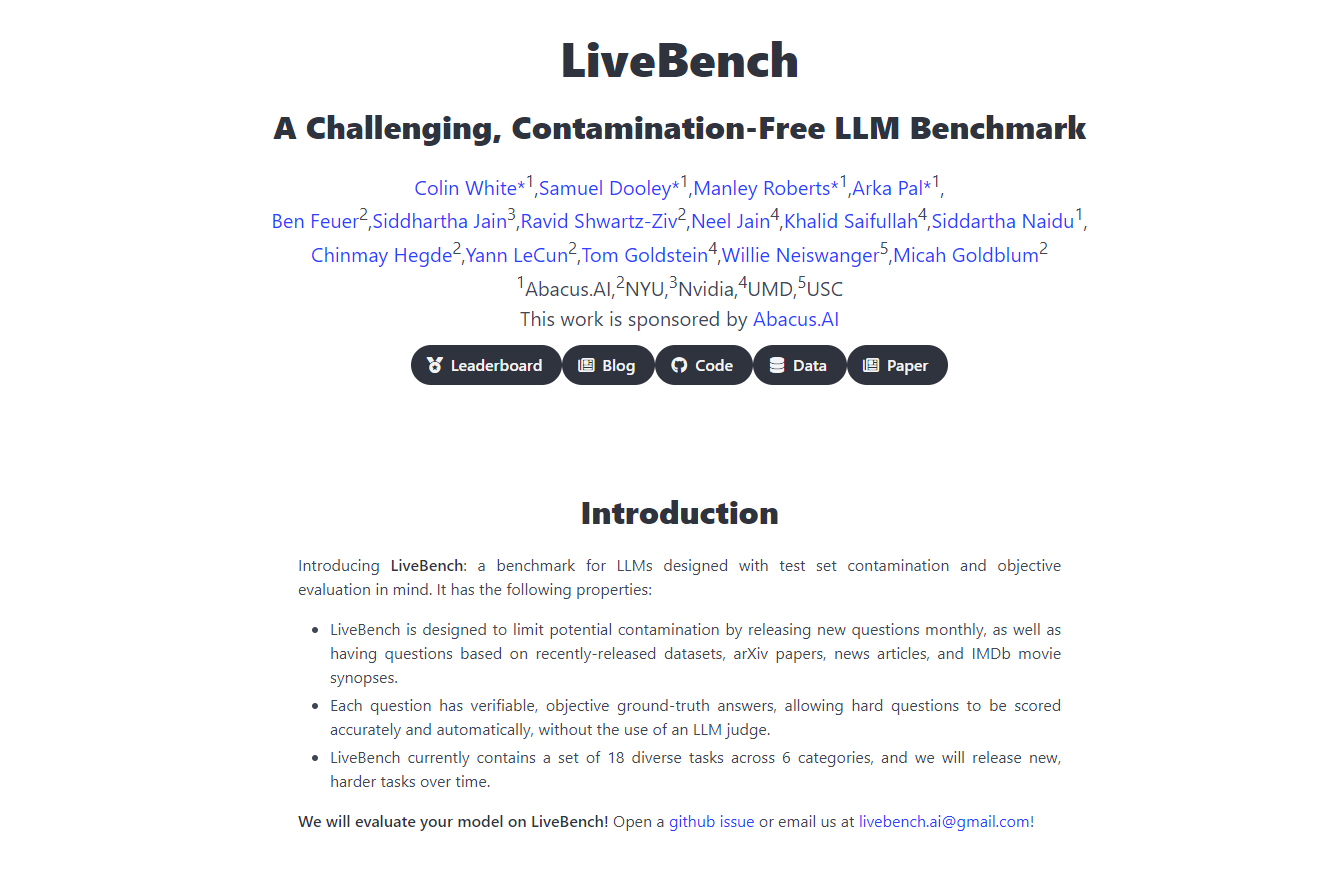

Yann LeCunn氏とそのチームとの共同開発により誕生した、革新的なベンチマークプラットフォーム、LiveBench AIをご紹介します。このプラットフォームは、これまで以上に大規模言語モデル(LLM)に挑戦し評価するために設計されています。継続的に更新されるこのベンチマークは、モデルが単に記憶できないような新しい課題を導入することで、正確で公平な評価を保証します。推論、プログラミング、ライティング、データ分析など、さまざまな側面でLLMを評価し、AI開発と展開に不可欠な、堅牢で公平かつ包括的な評価フレームワークを提供します。

主な機能

-

継続的な更新: LiveBenchは、最新のデータセット、arXiv論文、ニュース記事、IMDbサマリーに基づいて、毎月新しい質問を導入することで、記憶を防ぎ、LLMの能力を継続的に評価します。

-

客観的な採点: 各質問には検証可能な客観的な答えがあり、LLMの審査員を必要とせずに、正確で自動化された採点が可能です。これにより、評価の公平性が維持されます。

-

多様なタスク範囲: 現在、6つのカテゴリーにわたって18種類の異なるタスクを網羅しており、時間の経過とともに、より難しい新しいタスクがリリースされ、ベンチマークが挑戦的で関連性の高いものになります。

-

汚染防止設計: LiveBenchは、明確で客観的な答えを持つ質問のみを含むように構成されており、バイアスを最小限に抑え、評価の整合性を確保します。

-

評価の罠を回避: 本プラットフォームは、難しい質問の答えにおけるバイアスなど、従来のLLM評価方法の落とし穴を回避するために、客観的で検証可能な正確性に焦点を当てて開発されています。

ユースケース

-

AI研究開発: 研究者はLiveBenchを使用して、ダイナミックな課題セットに対してLLMのパフォーマンスを正確に測定し、AIの改善と革新を推進することができます。

-

テクノロジー企業のベンチマーク: テクノロジー企業はLiveBenchを使用して、さまざまなLLMの有効性を比較し、製品やサービスにどのモデルを統合するかについての意思決定を導き出すことができます。

-

教育評価: 教育者は、このプラットフォームを使用して、学生にLLMの能力と限界について教え、テストすることができます。これにより、AI評価と開発に関する実践的な洞察が得られます。

結論

LiveBench AIは、大規模言語モデルのための包括的で公平な、そして継続的に進化する評価ツールを提供することで、AIベンチマークの最前線に立っています。その革新的なアプローチは、LLM開発が現実世界の課題に基づいていることを保証し、より堅牢で信頼性の高いAIテクノロジーにつながります。LiveBench AIでAIの真の可能性を発見しましょう。AIの未来がテストされ、実証される場所です。

よくある質問

-

LiveBenchは他のAIベンチマークと比べて何がユニークですか?他のベンチマークとは異なり、LiveBenchは、明確で客観的な答えを持つ、ダイナミックな課題セットを使用しており、毎月更新されることで、記憶を防ぎ、LLMの能力を継続的かつ正確に評価できます。

-

LiveBenchはどのように評価の公平性を確保していますか?LiveBenchは、検証可能な客観的な答えを持つ質問に焦点を当て、LLM審査員による採点に頼らないことで、バイアスと公平性の問題を回避しています。これにより、公平な評価プロセスが維持されます。

-

LiveBenchは教育目的で使用できますか?もちろんです。LiveBenchは、教育者が学生にAI評価について教え、テストするために使用できる、実践的な現実世界のデータセットと課題を提供します。これは、貴重な教育リソースです。

More information on LiveBench

Top 5 Countries

Traffic Sources

LiveBench 代替

LiveBench 代替-

WildBenchは、現実世界のさまざまなタスクでLLMを評価する、高度なベンチマークツールです。AIのパフォーマンスを向上させ、実際のシナリオにおけるモデルの限界を理解したいと考えている人にとって不可欠です。

-

BenchLLM: LLMレスポンスを評価し、テストスイートを構築し、評価を自動化します。包括的なパフォーマンス評価により、AI駆動システムを強化します。

-

ノーコードのLLM評価で、AI製品をより迅速にローンチしましょう。180種類以上のモデルを比較し、プロンプトを作成し、自信を持ってテストできます。

-

あらゆる規模の企業が、自社の LLM が実稼働に値する理由を正当化するために Confident AI を利用しています。

-

xbench:現実世界での実用性と、フロンティア領域の能力を追跡するAIベンチマーク。独自のデュアルトラックシステムにより、AIエージェントの正確かつ動的な評価を提供します。