What is LiveBench?

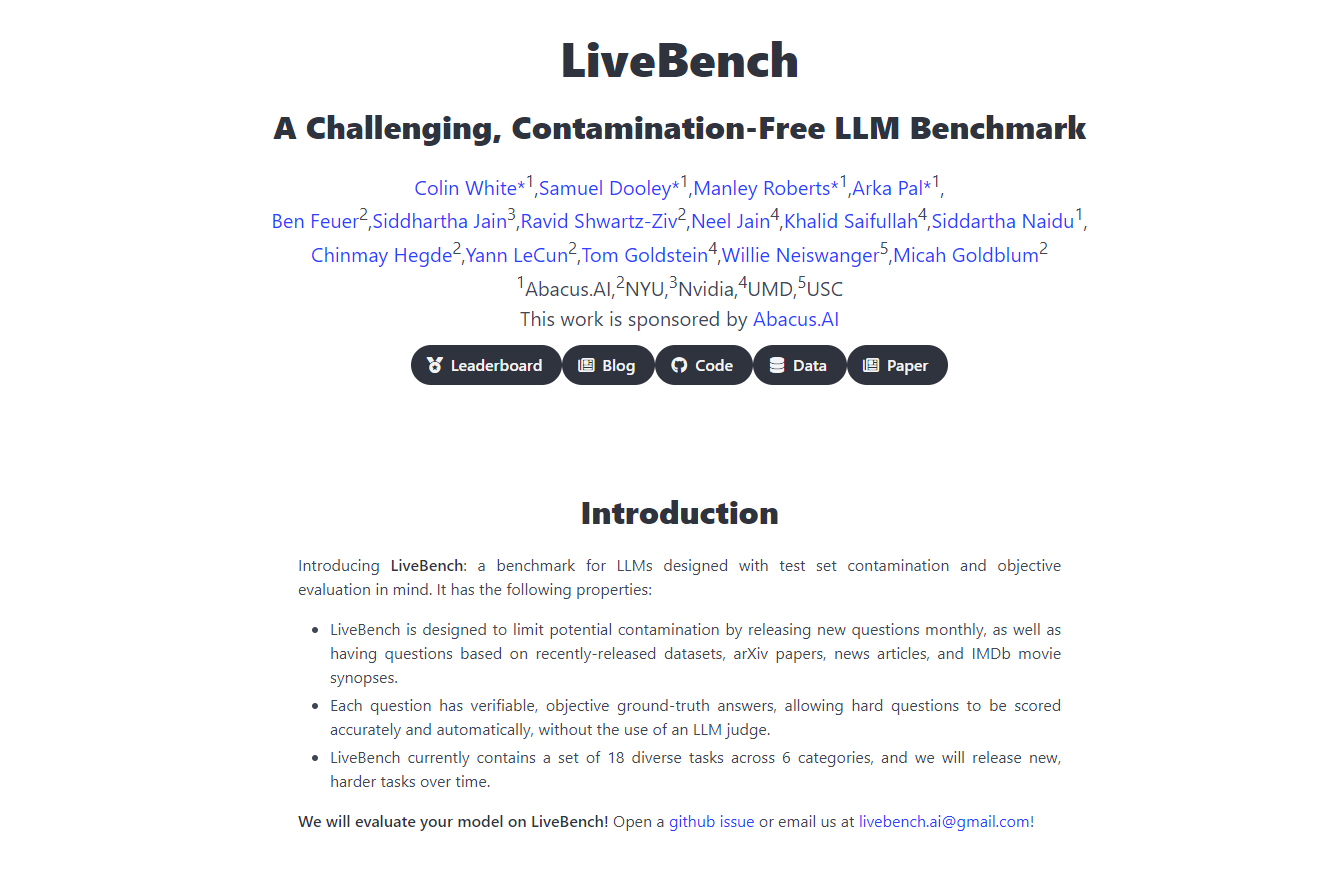

隆重推出 LiveBench AI,一个革命性的基准测试平台,由 Yann LeCunn 及其团队合作打造,旨在以前所未有的方式挑战和评估大型语言模型 (LLM)。这个持续更新的基准测试引入了新的挑战,这些挑战无法被模型简单地记忆,从而确保评估的准确性和公正性。它从推理、编程、写作和数据分析等多个维度评估 LLM,提供了一个稳健、公平、全面的评估框架,这对 AI 开发和部署至关重要。

主要功能

持续更新:LiveBench 每个月都会引入新的问题,这些问题基于最新的数据集、arXiv 论文、新闻文章和 IMDb 摘要,防止模型记忆,并确保对 LLM 能力的持续评估。

客观评分:每个问题都有一个可验证的客观答案,允许进行精确的自动评分,无需 LLM 评委,从而在评估中保持公平性。

多样化的任务范围:目前涵盖 6 个类别中的 18 个不同任务,随着时间的推移,将发布新的、更困难的任务,以保持基准测试的挑战性和相关性。

防污染设计:LiveBench 的结构只包含具有清晰、客观答案的问题,最大程度地减少偏差,确保评估的完整性。

避免评估陷阱:该平台旨在避开传统 LLM 评估方法的缺陷,例如硬性问题答案中的偏差,而是专注于客观、可验证的正确性。

用例

AI 研究与开发:研究人员可以使用 LiveBench 准确地衡量其 LLM 在一组动态挑战中的性能,从而推动 AI 的改进和创新。

科技公司基准测试:科技公司可以使用 LiveBench 来比较不同 LLM 的有效性,指导他们做出将哪些模型集成到其产品和服务中的决策。

教育评估:教育工作者可以使用该平台来教授和测试学生对 LLM 的能力和局限性的了解,从而提供对 AI 评估和开发的实用见解。

结论

LiveBench AI 站在 AI 基准测试的最前沿,为大型语言模型提供了一个全面、公平、不断发展的评估工具。其创新方法确保 LLM 开发以现实世界的挑战为基础,从而产生更强大、更可靠的 AI 技术。使用 LiveBench AI 发现 AI 的真正潜力 - 在这里,AI 的未来将得到检验和证明。

常见问题解答

与其他 AI 基准测试相比,LiveBench 的独特之处是什么?与其他基准测试不同,LiveBench 使用一组动态的挑战,这些挑战具有清晰、客观的答案,每月更新以防止记忆,确保对 LLM 能力的持续和准确评估。

LiveBench 如何确保其评估的公平性?LiveBench 通过专注于具有可验证、客观答案的问题,以及不依赖 LLM 评委评分来避免偏差和公平问题,从而保持公正的评估过程。

LiveBench 可以用于教育目的吗?当然可以。LiveBench 提供了实用的、现实世界的 dataset 和挑战,教育工作者可以使用它们来教授和测试学生关于 AI 评估的知识,使其成为宝贵的教育资源。