What is LiveBench?

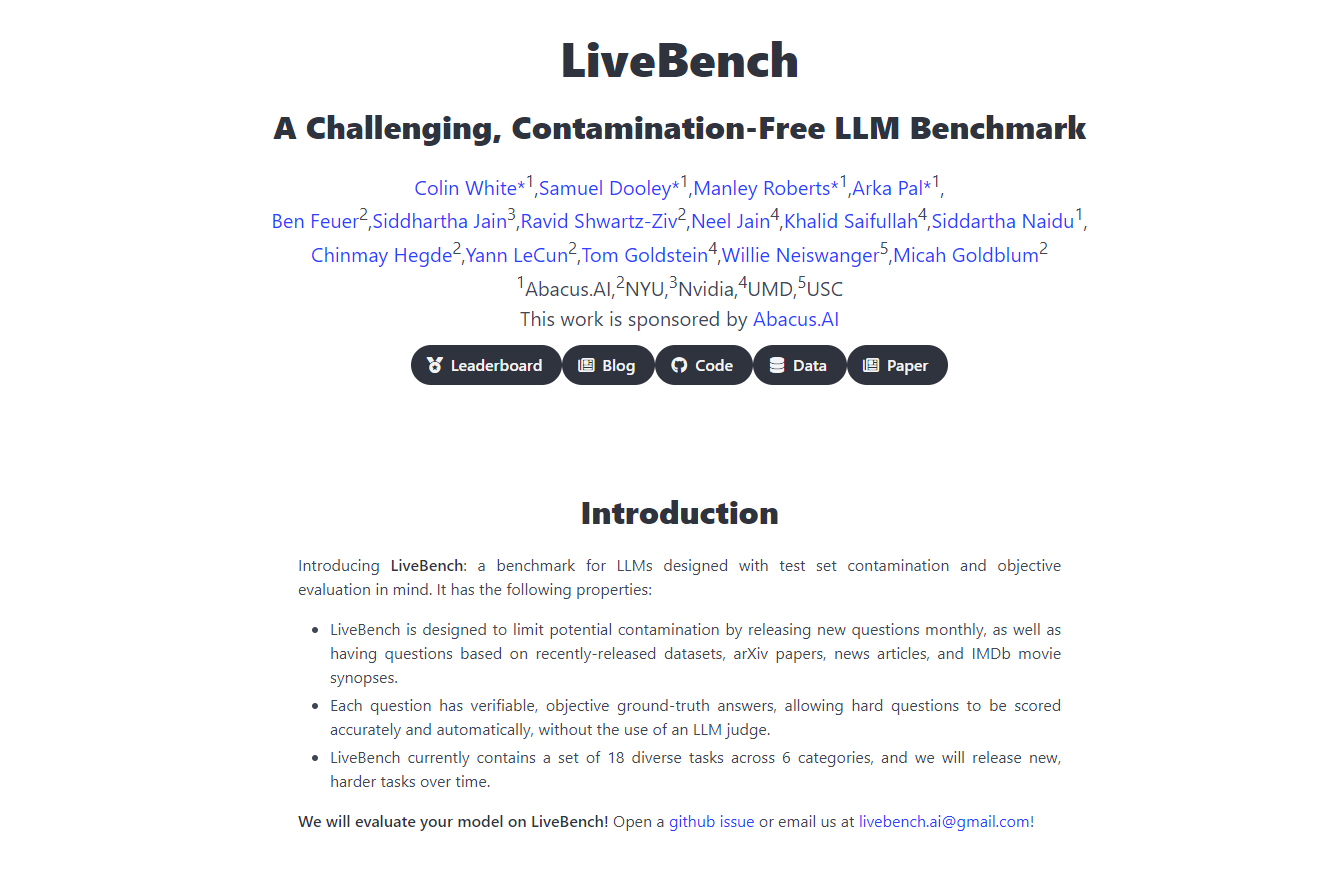

Yann LeCunn과 그의 팀과의 협업을 통해 탄생한 혁신적인 벤치마킹 플랫폼, LiveBench AI를 소개합니다. LiveBench AI는 기존과는 차원이 다른 방식으로 대규모 언어 모델(LLM)을 평가하고 도전하는 것을 목표로 합니다. 이 플랫폼은 지속적으로 업데이트되며, 모델이 단순히 암기할 수 없는 새로운 과제를 도입하여 정확하고 객관적인 평가를 보장합니다. LiveBench AI는 추론, 프로그래밍, 글쓰기, 데이터 분석 등 다양한 측면에서 LLM을 평가하여 AI 개발 및 배포에 필수적인 강력하고 공정하며 포괄적인 평가 프레임워크를 제공합니다.

주요 기능

지속적인 업데이트: LiveBench는 최신 데이터 세트, arXiv 논문, 뉴스 기사, IMDb 요약을 기반으로 매월 새로운 질문을 도입하여 모델의 암기를 방지하고 LLM 기능에 대한 지속적인 평가를 보장합니다.

객관적인 점수: 각 질문에는 검증 가능하고 객관적인 답변이 있으며, 이를 통해 LLM 심판 없이 정확하고 자동화된 점수를 매길 수 있어 공정한 평가를 유지합니다.

다양한 작업 범위: 현재 6개 카테고리에 걸쳐 18개의 서로 다른 작업을 포함하고 있으며, 시간이 지남에 따라 더 어려운 새로운 작업이 출시되어 벤치마크를 계속해서 도전적이고 관련성 있게 유지합니다.

오염 방지 설계: LiveBench는 명확하고 객관적인 답변이 있는 질문만 포함하도록 구성되어 편향을 최소화하고 평가의 무결성을 보장합니다.

평가 함정 피하기: 이 플랫폼은 객관적이고 검증 가능한 정확성에 중점을 두어 어려운 질문에 대한 답변의 편향과 같은 기존 LLM 평가 방법의 함정을 피하도록 개발되었습니다.

사용 사례

AI 연구 및 개발: 연구자들은 LiveBench를 사용하여 역동적인 과제 세트에 대한 LLM의 성능을 정확하게 측정하고 AI의 개선 및 혁신을 이끌어낼 수 있습니다.

기술 회사 벤치마킹: 기술 회사는 LiveBench를 사용하여 다양한 LLM의 효과를 비교하고 제품과 서비스에 통합할 모델을 결정하는 데 도움을 받을 수 있습니다.

교육 평가: 교육자들은 이 플랫폼을 사용하여 학생들에게 LLM의 기능과 한계에 대해 가르치고 평가하여 AI 평가 및 개발에 대한 실질적인 통찰력을 제공할 수 있습니다.

결론

LiveBench AI는 AI 벤치마킹의 선두 주자로서 대규모 언어 모델을 위한 포괄적이고 공정하며 지속적으로 발전하는 평가 도구를 제공합니다. LiveBench AI의 혁신적인 접근 방식은 LLM 개발이 실제 세계의 과제를 기반으로 이루어지도록 하여 보다 강력하고 신뢰할 수 있는 AI 기술로 이어집니다. AI의 진정한 잠재력을 LiveBench AI에서 발견하세요. AI의 미래가 시험되고 증명되는 곳입니다.

FAQ

LiveBench는 다른 AI 벤치마크와 어떤 점이 다릅니까? 다른 벤치마크와 달리 LiveBench는 명확하고 객관적인 답변을 가진 역동적인 과제 세트를 사용하며, 매월 업데이트되어 암기를 방지하고 LLM 기능에 대한 지속적이고 정확한 평가를 보장합니다.

LiveBench는 어떻게 평가의 공정성을 보장합니까? LiveBench는 검증 가능하고 객관적인 답변이 있는 질문에 중점을 두고 LLM 심판에 의존하지 않아 공정한 평가 프로세스를 유지하여 편향과 공정성 문제를 피합니다.

LiveBench를 교육 목적으로 사용할 수 있습니까? 물론입니다. LiveBench는 교육자가 AI 평가에 대해 학생들을 가르치고 평가하는 데 사용할 수 있는 실질적이고 실제 세계의 데이터 세트와 과제를 제공하여 귀중한 교육 자료가 됩니다.

More information on LiveBench

Top 5 Countries

Traffic Sources

LiveBench 대안

LiveBench 대안-

WildBench는 다양한 실제 작업 세트에서 LLM을 평가하는 고급 벤치마킹 도구입니다. 실제 시나리오에서 AI 성능을 향상시키고 모델의 한계를 이해하려는 사람들에게 필수적입니다.

-

BenchLLM: LLM 응답 평가, 테스트 세트 구축, 평가 자동화. 포괄적인 성능 평가를 통해 AI 기반 시스템을 향상시킵니다.

-

노코드 LLM 평가로 AI 제품 출시 속도를 높이세요. 180개 이상의 모델을 비교하고, 프롬프트를 만들고, 자신 있게 테스트하세요.

-

모든 규모의 회사가 Confident AI를 사용하여 자사의 LLM이 운영에 적합한 이유를 정당화하고 있습니다.

-

xbench: 실제 활용성과 최첨단 역량을 측정하는 AI 벤치마크. 당사의 듀얼 트랙 시스템으로 AI 에이전트의 정확하고 역동적인 평가를 제공합니다.