What is LiveBench?

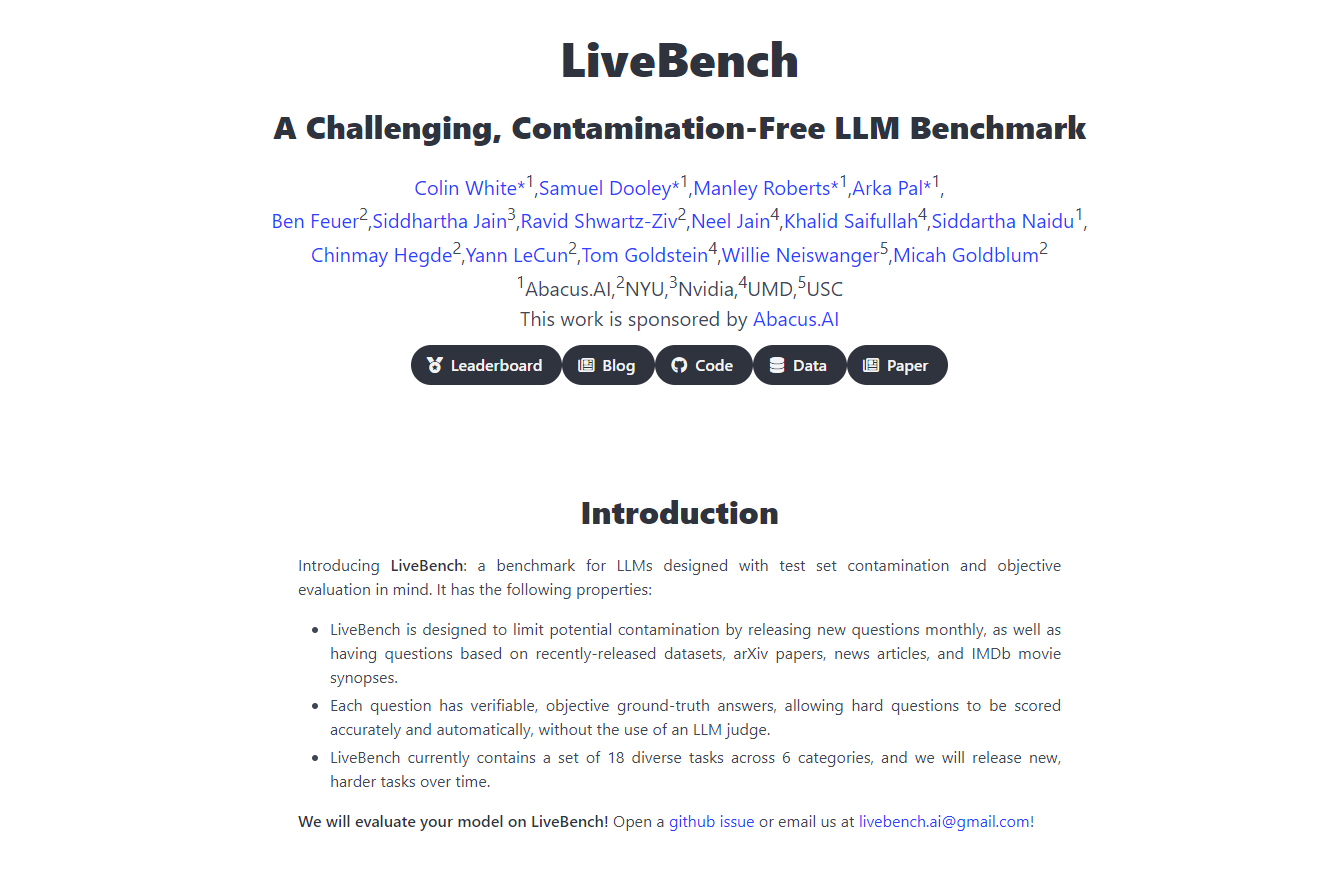

Découvrez LiveBench AI, une plateforme révolutionnaire de benchmarking conçue en collaboration avec Yann LeCunn et son équipe, destinée à mettre au défi et à évaluer les grands modèles de langage (LLM) comme jamais auparavant. Cette référence constamment mise à jour introduit de nouveaux défis qui ne peuvent pas être simplement mémorisés par les modèles, garantissant ainsi des évaluations précises et impartiales. Elle évalue les LLM sur différentes dimensions, notamment le raisonnement, la programmation, l'écriture et l'analyse de données, offrant un cadre d'évaluation robuste, équitable et complet, essentiel au développement et au déploiement de l'IA.

Fonctionnalités clés

Mises à jour continues : LiveBench introduit de nouvelles questions chaque mois, basées sur des jeux de données récents, des articles arXiv, des articles de presse et des résumés IMDb, empêchant la mémorisation et assurant une évaluation continue des capacités des LLM.

Évaluation objective : Chaque question a une réponse vérifiable et objective, permettant une notation précise et automatisée sans avoir besoin de juges LLM, garantissant ainsi l'équité dans l'评估.

Gamme de tâches diversifiée : Actuellement, elle englobe 18 tâches différentes réparties en 6 catégories, avec de nouvelles tâches plus difficiles publiées au fil du temps pour maintenir la pertinence et la difficulté de la référence.

Conception anti-contamination : LiveBench est structuré pour inclure uniquement des questions ayant des réponses claires et objectives, minimisant ainsi les biais et garantissant l'intégrité de l'évaluation.

Éviter les pièges d'évaluation : La plateforme est développée pour contourner les pièges des méthodes d'évaluation LLM traditionnelles, telles que les biais dans les réponses aux questions difficiles, en se concentrant sur l'exactitude objective et vérifiable.

Cas d'utilisation

Recherche et développement en IA : Les chercheurs peuvent utiliser LiveBench pour évaluer avec précision les performances de leurs LLM face à un ensemble dynamique de défis, stimulant ainsi les améliorations et les innovations dans l'IA.

Benchmarking des entreprises technologiques : Les entreprises technologiques peuvent utiliser LiveBench pour comparer l'efficacité de différents LLM, guidant ainsi les décisions sur les modèles à intégrer dans leurs produits et services.

Évaluation pédagogique : Les éducateurs peuvent utiliser la plateforme pour enseigner et tester les élèves sur les capacités et les limites des LLM, fournissant ainsi des informations pratiques sur l'évaluation et le développement de l'IA.

Conclusion

LiveBench AI se positionne à la pointe du benchmarking de l'IA, offrant un outil d'évaluation complet, équitable et en constante évolution pour les grands modèles de langage. Son approche novatrice garantit que le développement des LLM est ancré dans des défis du monde réel, conduisant à des technologies d'IA plus robustes et fiables. Découvrez le véritable potentiel de l'IA avec LiveBench AI, où l'avenir de l'IA est testé et prouvé.

FAQ

En quoi LiveBench est-il unique par rapport aux autres références d'IA ? Contrairement aux autres références, LiveBench utilise un ensemble dynamique de défis avec des réponses claires et objectives, mises à jour mensuellement pour empêcher la mémorisation, garantissant ainsi une évaluation continue et précise des capacités des LLM.

Comment LiveBench garantit-il l'équité de ses évaluations ? LiveBench évite les biais et les problèmes d'équité en se concentrant sur des questions ayant des réponses vérifiables et objectives et en ne s'appuyant pas sur des juges LLM pour la notation, ce qui maintient un processus d'评估impartial.

LiveBench peut-il être utilisé à des fins éducatives ? Absolument. LiveBench fournit un ensemble de données et des défis pratiques et concrets qui peuvent être utilisés par les éducateurs pour enseigner et tester les élèves sur l'évaluation de l'IA, en faisant une ressource éducative inestimable.

More information on LiveBench

Top 5 Countries

Traffic Sources

LiveBench Alternatives

Plus Alternatives-

WildBench est un outil de benchmark avancé qui évalue les LLM sur un ensemble diversifié de tâches du monde réel. Il est essentiel pour ceux qui cherchent à améliorer les performances de l'IA et à comprendre les limites des modèles dans des scénarios pratiques.

-

BenchLLM : Évaluez les réponses des LLM, construisez des suites de tests, automatisez les évaluations. Améliorez les systèmes pilotés par l’IA grâce à des évaluations de performance complètes.

-

Lancez plus rapidement vos produits d'IA grâce aux évaluations LLM sans code. Comparez plus de 180 modèles, concevez des invites et testez en toute confiance.

-

Les entreprises de toutes tailles utilisent Confident AI pour justifier la mise en production de leur LLM.

-