What is LiveBench?

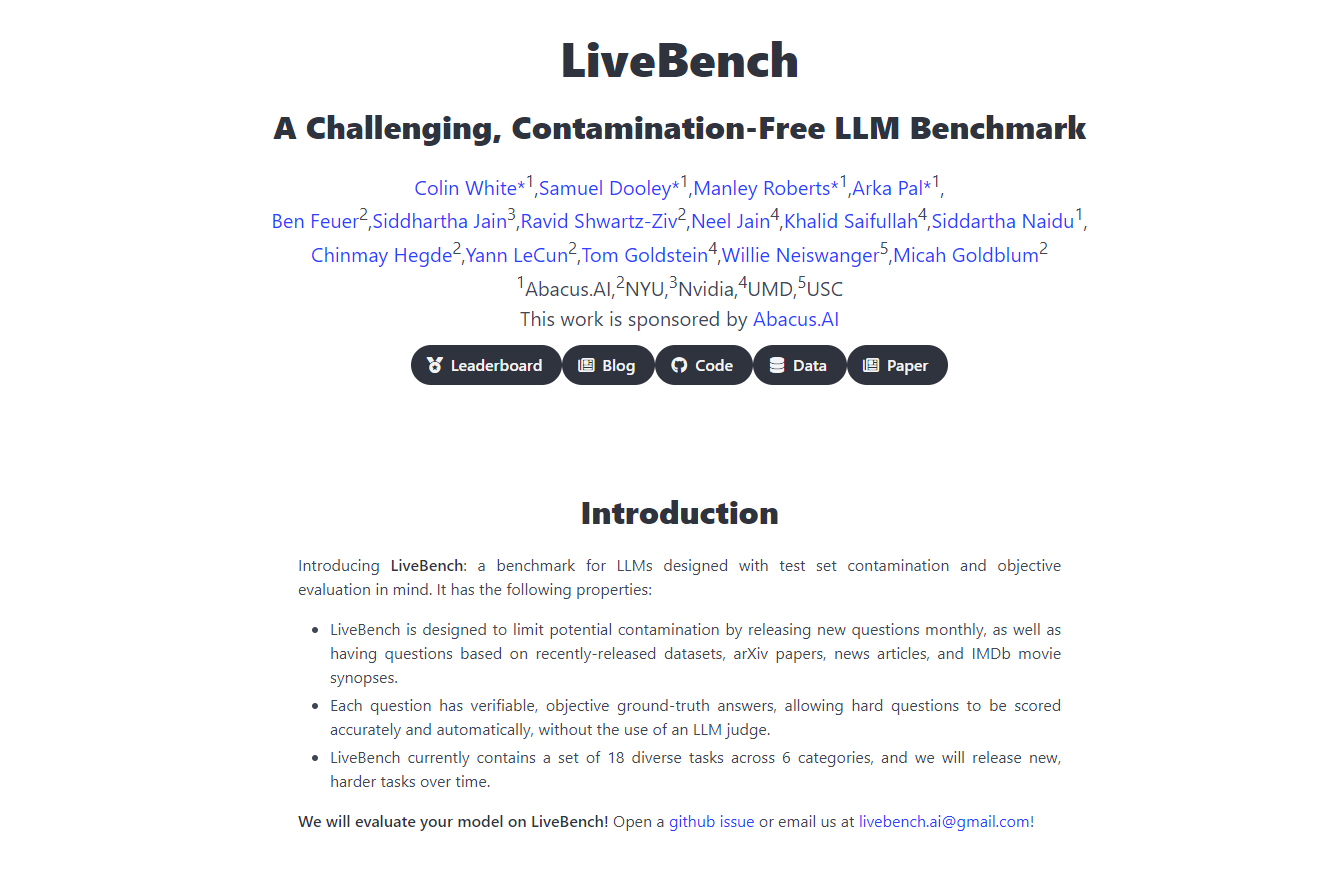

隆重推出 LiveBench AI,這是一個革命性的基準測試平台,由 Yann LeCunn 及其團隊共同打造,旨在以前所未有的方式挑戰和評估大型語言模型 (LLM)。這個不斷更新的基準測試引入了新的挑戰,這些挑戰無法被模型簡單地記憶,確保評估的準確性和公正性。它從推理、編程、寫作和數據分析等多個方面評估 LLM,提供了一個強大、公平且全面的評估框架,對於 AI 的開發和部署至關重要。

主要功能

持續更新:LiveBench 每月都會根據最新的數據集、arXiv 論文、新聞文章和 IMDb 摘要引入新的問題,防止記憶,確保對 LLM 能力的持續評估。

客觀評分:每個問題都有可驗證的客觀答案,允許精確的自動評分,無需 LLM 評審,從而保持評估的公平性。

多樣化的任務範圍:目前涵蓋 6 個類別的 18 個不同任務,隨著時間的推移,將發布新的、更難的任務,以保持基準測試的挑戰性和相關性。

反污染設計:LiveBench 的結構僅包含具有明確、客觀答案的問題,最大程度地減少偏差,並確保評估的完整性。

避免評估陷阱:該平台的開發旨在避開傳統 LLM 評估方法的陷阱,例如難題答案中的偏差,而是專注於客觀、可驗證的正確性。

用例

AI 研究與開發:研究人員可以使用 LiveBench 來準確衡量其 LLM 在動態挑戰集中的性能,推動 AI 的改進和創新。

科技公司基準測試:科技公司可以使用 LiveBench 來比較不同 LLM 的有效性,指導他們在將哪些模型集成到其產品和服務中的決策。

教育評估:教育工作者可以使用該平台來教授和測試學生對 LLM 的能力和局限性,提供對 AI 評估和開發的實用見解。

結論

LiveBench AI 處於 AI 基準測試的最前沿,為大型語言模型提供了一個全面、公平且不斷發展的評估工具。其創新方法確保 LLM 的開發以現實世界的挑戰為基礎,從而產生更強大和可靠的 AI 技術。使用 LiveBench AI 發現 AI 的真正潛力——在這裡,AI 的未來得到測試和驗證。

常見問題解答

與其他 AI 基準測試相比,LiveBench 的獨特之處是什麼?與其他基準測試不同,LiveBench 使用一組動態的挑戰,這些挑戰具有明確、客觀的答案,每月更新以防止記憶,確保對 LLM 能力的持續和準確的評估。

LiveBench 如何確保其評估的公平性?LiveBench 通過專注於具有可驗證、客觀答案的問題以及不依賴 LLM 評審進行評分來避免偏差和公平性問題,這保持了一個公正的評估過程。

LiveBench 可以用於教育目的嗎?絕對可以。LiveBench 提供了一個實用的、現實世界的數據集和挑戰,教育工作者可以使用這些數據集和挑戰來教授和測試學生對 AI 評估,使其成為寶貴的教育資源。