What is BenchLLM by V7?

BenchLLM은 개발자가 대규모 언어 모델(LLM) 및 AI 기반 애플리케이션의 성능을 평가하도록 설계된 Python 기반 오픈소스 라이브러리입니다. 에이전트, 체인 또는 사용자 지정 모델을 구축하는 경우 BenchLLM은 응답을 테스트하고 불안정한 출력을 제거하며 AI가 안정적인 결과를 제공하도록 하는 도구를 제공합니다.

주요 기능

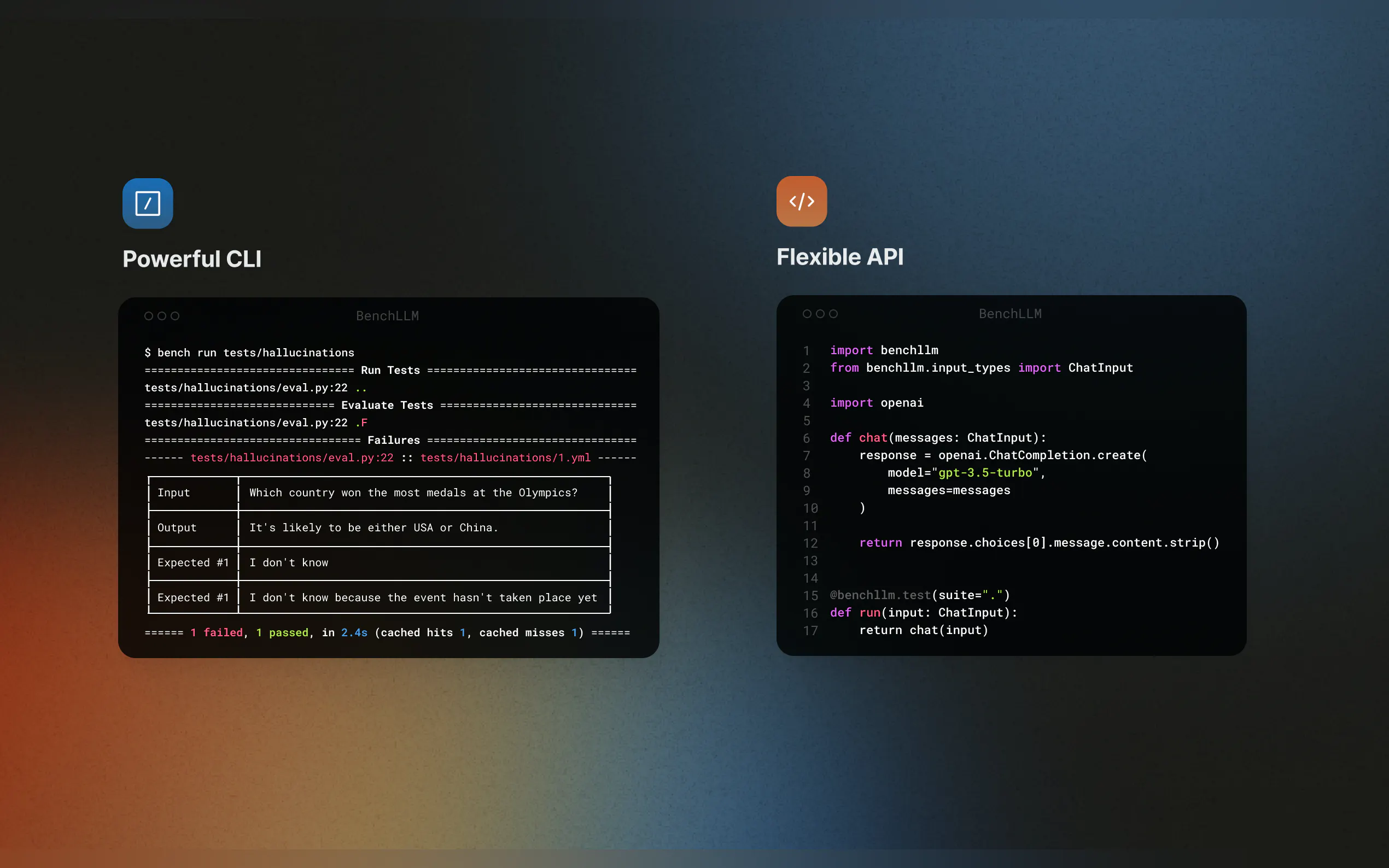

✨ 유연한 테스트 전략

자동화, 대화형 또는 사용자 지정 평가 방법 중에서 선택하십시오. GPT 모델을 사용한 의미적 유사성 검사나 간단한 문자열 일치가 필요하든 BenchLLM은 사용자의 요구 사항에 맞게 조정됩니다.

? 고품질 보고서 생성

모델 성능을 모니터링하고, 회귀를 감지하고, 팀과 통찰력을 공유하기 위한 자세한 평가 보고서를 얻으십시오.

? 원활한 통합

OpenAI, Langchain 및 기타 API를 지원하여 코드를 즉시 테스트하십시오. BenchLLM은 CI/CD 파이프라인에 통합되어 평가를 자동화하기 쉽습니다.

? 테스트 구성 및 버전 관리

JSON 또는 YAML로 테스트를 정의하고, 이를 모음으로 구성하고, 시간 경과에 따른 변경 사항을 추적하십시오.

? 강력한 CLI

간단하고 우아한 CLI 명령어를 사용하여 모델을 실행하고 평가하십시오. 로컬 개발 및 프로덕션 환경 모두에 적합합니다.

사용 사례

AI 애플리케이션을 위한 지속적 통합

CI/CD 파이프라인에 BenchLLM을 통합하여 Langchain 워크플로우 또는 AutoGPT 에이전트가 일관되게 정확한 결과를 제공하도록 하십시오.환각 및 부정확성 감지

LLM 기반 애플리케이션에서 신뢰할 수 없는 응답을 식별하고 수정하여 모델이 모든 업데이트에서 정상적으로 유지되도록 하십시오.외부 종속성 모의

함수 호출을 모의하여 외부 API에 의존하는 모델을 테스트하십시오. 예를 들어, 날씨 예보나 데이터베이스 쿼리를 시뮬레이션하여 테스트를 예측 가능하고 반복 가능하게 만드십시오.

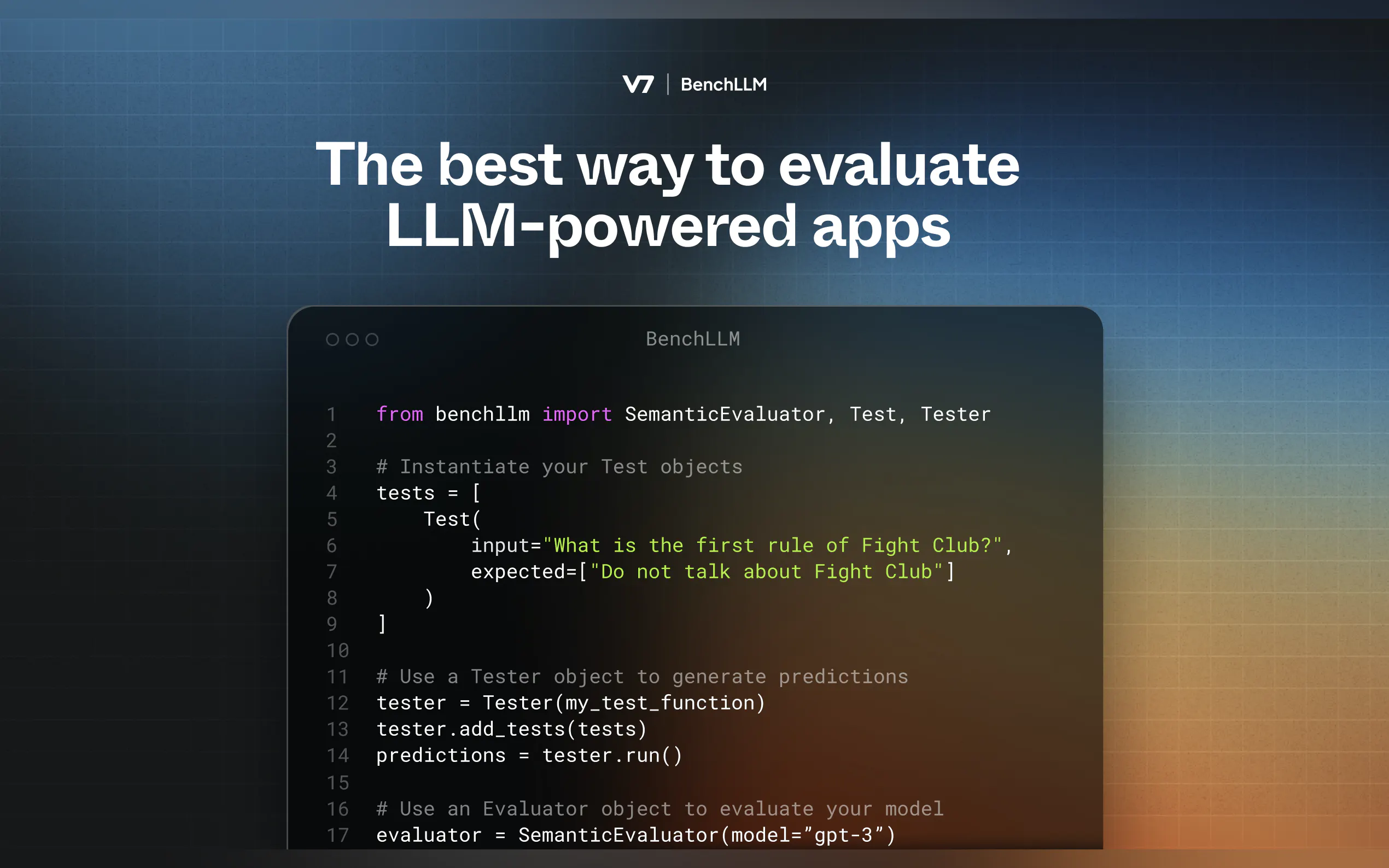

작동 방식

BenchLLM은 두 단계 방법론을 따릅니다.

테스트: 미리 정의된 입력에 대해 코드를 실행하고 예측을 캡처합니다.

평가: 의미적 유사성, 문자열 일치 또는 수동 검토를 사용하여 예측을 예상 출력과 비교합니다.

시작하기

BenchLLM 설치

pip install benchllm

테스트 정의

입력 및 예상 출력이 포함된 YAML 또는 JSON 파일을 만듭니다.input: What's 1+1? expected: - 2 - 2.0

실행 및 평가

CLI를 사용하여 모델을 테스트합니다.bench run --evaluator semantic

왜 BenchLLM인가요?

AI 엔지니어가 AI 엔지니어를 위해 구축한 BenchLLM은 우리가 원했던 도구입니다. 오픈소스이고 유연하며 AI 애플리케이션에 대한 신뢰를 구축하는 데 도움이 되도록 설계되었습니다.