Las mejores Baichuan-7B alternativas en 2025

-

Hunyuan-MT-7B: Traducción automática de IA de código abierto. Domina más de 33 idiomas con una precisión contextual y cultural insuperable. Ganador de WMT2025, ligero y eficiente.

-

Eagle 7B: superando a los transformadores con 1 billón de tokens en más de 100 idiomas (RWKV-v5)

-

Baichuan-M2: IA médica avanzada para el razonamiento clínico en entornos reales. Mejora el diagnóstico, optimiza los resultados para los pacientes y permite una implementación privada en una única GPU.

-

GLM-130B: un modelo preentrenado bilingüe abierto (ICLR 2023)

-

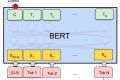

Código de TensorFlow y modelos preentrenados para BERT

-

ChatGLM-6B es un modelo abierto CN&EN con 6.2B paras (optimizados para respuesta a preguntas y diálogos en chino por ahora).

-

El gran modelo de lenguaje desarrollado por Tencent posee una potente capacidad de creación en chino. Razonamiento lógico en contextos complejos y ejecución fiable de tareas

-

Desbloquea el poder de YaLM 100B, una red neuronal similar a GPT que genera y procesa texto con 100 mil millones de parámetros. Gratuito para desarrolladores e investigadores de todo el mundo.

-

Yuan2.0-M32 es un modelo de lenguaje de Mezcla de Expertos (MoE) con 32 expertos, de los cuales 2 están activos.

-

Qwen2 es la serie de modelos de lenguaje de gran tamaño desarrollada por el equipo de Qwen, Alibaba Cloud.

-

Descubre cómo TextGen revoluciona las tareas de generación de idioma con una compatibilidad amplia de modelos. Crea contenido, desarrolla chatbots y aumenta los conjuntos de datos sin esfuerzo.

-

XVERSE-MoE-A36B: Un modelo lingüístico de gran tamaño multilingüe desarrollado por XVERSE Technology Inc.

-

BAGEL: IA multimodal de código abierto de ByteDance-Seed. Comprende, genera y edita imágenes y texto. Potente, flexible y comparable a GPT-4o. Desarrolle aplicaciones de IA avanzadas.

-

Investigación en curso para entrenar modelos Transformer a escala

-

Una interfaz de usuario web de Gradio para modelos de lenguaje grandes. Admite transformadores, GPTQ, llama.cpp (GGUF), modelos Llama.

-

MiniCPM3-4B es la tercera generación de la serie MiniCPM. El rendimiento general de MiniCPM3-4B supera a Phi-3.5-mini-Instruct y GPT-3.5-Turbo-0125, siendo comparable con muchos modelos recientes de 7B~9B.

-

GLM-4-9B es la versión de código abierto de la última generación de modelos pre-entrenados en la serie GLM-4, lanzada por Zhipu AI.

-

MiniCPM es un LLM de fin lateral desarrollado por ModelBest Inc. y TsinghuaNLP, con solo 2.4B parámetros excluyendo incrustaciones (2.7B en total).

-

DeepSeek LLM, un modelo de lenguaje avanzado compuesto por 67 mil millones de parámetros. Ha sido entrenado desde cero en un amplio conjunto de datos de 2 billones de tokens en inglés y chino.

-

Descubre EXAONE 3.5 de LG AI Research. Un conjunto de modelos generativos ajustados por instrucciones bilingües (inglés y coreano) con parámetros que van de 2.4 mil millones a 32 mil millones. Admite contextos largos de hasta 32 mil tokens, con un rendimiento de primer nivel en escenarios del mundo real.

-

WizardLM-2 8x22B es el modelo Wizard más avanzado de Microsoft AI. Demuestra un rendimiento altamente competitivo en comparación con los principales modelos propietarios y supera constantemente a todos los modelos de código abierto de última generación existentes.

-

C4AI Aya Vision 8B: IA de visión multilingüe de código abierto para la comprensión de imágenes. Reconocimiento óptico de caracteres (OCR), subtitulado y razonamiento en 23 idiomas.

-

OpenBMB: Creación de un centro de modelos de lenguaje preentrenados a gran escala y herramientas para acelerar la formación, el ajuste y la inferencia de modelos grandes con más de 10 mil millones de parámetros. Únete a nuestra comunidad de código abierto y haz que los modelos grandes lleguen a todos.

-

Libera el poder de la IA para tareas agentivas con LongCat-Flash. El MoE LLM de código abierto ofrece un rendimiento sin precedentes y una inferencia ultrarrápida y rentable.

-

Descubre StableLM, un modelo de lenguaje de código abierto de Stability AI. Genera texto y código de alto rendimiento en dispositivos personales con modelos pequeños y eficientes. Tecnología de IA transparente, accesible y de apoyo para desarrolladores e investigadores.

-

Qwen2.5-Turbo by Alibaba Cloud. Ventana de contexto de 1M de tokens. Más rápido y económico que la competencia. Ideal para investigación, desarrollo y negocios. Resume documentos, analiza archivos. Crea IA conversacional avanzada.

-

Los modelos de lenguaje de la serie Qwen2.5 ofrecen capacidades mejoradas con conjuntos de datos más grandes, más conocimiento, mejores habilidades de codificación y matemáticas, y una alineación más cercana a las preferencias humanas. De código abierto y disponible a través de API.

-

JetMoE-8B se entrenó con un costo de menos de $ 0,1 millones, pero supera a LLaMA2-7B de Meta AI, que cuenta con recursos de capacitación multimillonarios. La capacitación de LLM puede ser mucho más económica de lo que generalmente se cree.

-

Jina ColBERT v2 admite 89 idiomas con un rendimiento de recuperación superior, dimensiones de salida controladas por el usuario y una longitud de token de 8192.

-

GPT-NeoX-20B es un modelo de lenguaje autoregresivo de 20 mil millones de parámetros entrenado en el Conjunto de Datos utilizando la biblioteca GPT-NeoX.