2025年最好的 Baichuan-7B 替代方案

-

Hunyuan-MT-7B:開源AI機器翻譯。掌握逾33種語言,具備無與倫比的語境與文化精準度。WMT2025年冠軍,輕巧高效。

-

-

Baichuan-M2:專為真實世界臨床推論設計的先進醫療人工智慧。協助診斷、提升病患預後,並可於單一GPU上進行私有化部署。

-

-

-

-

-

解鎖 YaLM 100B 的強大力量,一個類似 GPT 的神經網絡,擁有 1000 億個參數,可以生成和處理文字。全球開發者和研究人員免費使用。

-

-

-

發現 TextGen 如何透過廣泛的模型相容性徹底革新語言生成任務。輕鬆建立內容、開發聊天機器人和擴增數據集。

-

XVERSE-MoE-A36B:由 XVERSE Technology Inc. 開發的多語言大型語言模型。

-

BAGEL:字節跳動-Seed 開源的多模態人工智慧模型。能理解、生成、編輯圖像和文字。功能強大、靈活,堪比 GPT-4o。可用於構建先進的人工智慧應用程式。

-

-

Gradio 網頁 UI,適用於大型語言模型。支援變形金剛、GPTQ、llama.cpp(GGUF)、Llama 模型。

-

MiniCPM3-4B 是 MiniCPM 系列的第三代。MiniCPM3-4B 的整體效能超越了 Phi-3.5-mini-Instruct 和 GPT-3.5-Turbo-0125,與許多近期 7B~9B 模型相當。

-

-

MiniCPM 是由 ModelBest Inc. 和 TsinghuaNLP 開發的 End-Side LLM,不包含嵌入函數的參數只有 2.4B 個(總計 2.7B 個)。

-

DeepSeek LLM,一個由 670 億個參數組成的先進語言模型。它已經從一個在英語和中文皆包含 2 兆個詞彙的龐大資料集中,從頭開始接受訓練。

-

探索LG AI Research的EXAONE 3.5。這是一套雙語(英語和韓語)指令微調生成式模型,參數規模從24億到320億不等。支援長達32K個詞元的長上下文處理,在真實場景中表現卓越。

-

WizardLM-2 8x22B 是 Microsoft AI 最先進的 Wizard 模型。與領先的專有模型相比,它展現出極具競爭力的表現,並且持續勝過所有現有的最先進開源模型。

-

C4AI Aya Vision 8B:開源多語言視覺 AI,用於圖像理解。支援 23 種語言的 OCR、圖像描述和推理。

-

OpenBMB:建立大型預訓練語言模型中心與工具,以加速訓練、微調和推論超過 100 億參數的大型模型。加入我們的開放原始碼社群,讓每個人都能使用大型模型。

-

LongCat-Flash 助您解鎖強大AI,輕鬆駕馭代理式任務。這款開源 MoE LLM 不僅提供無與倫比的效能,更兼具高性價比與極速推論。

-

探索 Stability AI 推出的開源語言模型 StableLM。透過小巧高效的模型,在個人裝置上生成高性能的文字和程式碼。這項 AI 技術透明、易於取得且支援完善,專為開發者和研究人員而設計。

-

阿里雲 Qwen2.5-Turbo。100萬詞元上下文視窗。速度更快,價格更低。非常適合研究、開發和商業應用。可摘要論文、分析文件,並建構進階對話式 AI。

-

Qwen2.5 系列語言模型提供增強的功能,包括更大的資料集、更豐富的知識、更強的編碼和數學技能,以及更符合人類偏好的對齊。 它是開源的,可透過 API 取得。

-

JetMoE-8B 在不到 0.1 百萬美元1 的成本下進行訓練,但效能卻超越 Meta AI 的 LLaMA2-7B,而 Meta AI 擁有數十億美元的訓練資源。LLM 訓練可以比一般人想像中便宜許多。

-

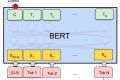

Jina ColBERT v2 支援 89 種語言,提供卓越的搜尋效能、使用者可控的輸出維度以及 8192 個 Token 長度。

-

GPT-NeoX-20B 是一個 200 億參數的自動回歸語言模型,使用 GPT-NeoX 函式庫針對 Pile 進行訓練。