2025 Лучших Baichuan-7B Альтернативи

-

Hunyuan-MT-7B: Машинный перевод на базе ИИ с открытым исходным кодом. Поддерживает более 33 языков, обеспечивая непревзойденную контекстуальную и культурную точность. Победитель WMT2025, легковесный и эффективный.

-

Eagle 7B: Совершая пролет над Transformers с 1 триллионом токенов более чем на 100 языках (RWKV-v5)

-

Baichuan-M2: Передовой медицинский ИИ для клинического мышления в реальных условиях. Обосновывает диагнозы, улучшает результаты лечения пациентов и развертывается конфиденциально на одном GPU.

-

GLM-130B: открытая предварительно обученная двуязычная модель (ICLR 2023)

-

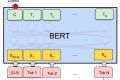

TensorFlow код и предварительно обученные модели для BERT

-

ChatGLM-6B — открытая модель CN&EN с 6,2B парами (на данный момент оптимизирована для китайских вопросов и ответов и диалогов).

-

Крупная языковая модель, разработанная Tencent, обладает мощными способностями к созданию на китайском языке. Логическое обоснование в сложных контекстах и надежное выполнение заданий

-

Разблокируйте возможности YaLM 100B, нейронной сети типа GPT, которая генерирует и обрабатывает текст с 100 миллиардами параметров. Доступно бесплатно для разработчиков и исследователей по всему миру.

-

Yuan2.0-M32 — это языковая модель, основанная на архитектуре "смесь экспертов" (MoE) с 32 экспертами, из которых активны 2.

-

Qwen2 - это серия больших языковых моделей, разработанная командой Qwen, Alibaba Cloud.

-

Узнайте, как TextGen революционизирует задачи генерации языка благодаря широкой совместимости моделей. Создавайте контент, разрабатывайте чат-боты и дополняйте наборы данных без особых усилий.

-

XVERSE-MoE-A36B: Многоязычная большая языковая модель, разработанная XVERSE Technology Inc.

-

BAGEL: мультимодальная AI с открытым исходным кодом от ByteDance-Seed. Понимает, генерирует и редактирует изображения и текст. Мощная, гибкая, по своим возможностям сопоставима с GPT-4o. Создавайте передовые AI-приложения.

-

Продолжающееся обучение исследовательских моделей трансформаторов в масштабе

-

Gradio: веб-интерфейс для больших языковых моделей. Поддерживает трансформаторы, GPTQ, llama.cpp (GGUF), модели Llama.

-

MiniCPM3-4B - это третье поколение серии MiniCPM. В целом, производительность MiniCPM3-4B превосходит Phi-3.5-mini-Instruct и GPT-3.5-Turbo-0125, будучи сопоставимой со многими современными моделями размером 7B~9B.

-

GLM-4-9B - это версия с открытым исходным кодом последнего поколения предварительно обученных моделей в серии GLM-4, выпущенных компанией Zhipu AI.

-

MiniCPM — это End-Side LLM, разработанная ModelBest Inc. и TsinghuaNLP, с всего 2,4 млрд параметрами, исключая встраивание (всего 2,7 млрд).

-

DeepSeek LLM, передовая языковая модель, включающая 67 миллиардов параметров. Она была обучена с нуля на обширном наборе данных в 2 триллиона токенов как на английском, так и на китайском языках.

-

Откройте для себя EXAONE 3.5 от LG AI Research. Это набор двуязычных (английский и корейский) генеративных моделей, настроенных на инструкции, с количеством параметров от 2,4 миллиардов до 32 миллиардов. Поддерживает длинный контекст до 32 тысяч токенов и демонстрирует первоклассные результаты в реальных сценариях.

-

WizardLM-2 8x22B — самая продвинутая модель Wizard от Microsoft AI. Она демонстрирует высокую конкурентоспособность по сравнению с ведущими коммерческими моделями и превосходит все существующие передовые модели с открытым исходным кодом.

-

C4AI Aya Vision 8B: Многоязычная нейросеть с открытым исходным кодом для анализа изображений. Распознавание текста (OCR), создание подписей и логический вывод на 23 языках.

-

OpenBMB: создание центра крупномасштабных предварительно обученных языковых моделей и инструментов для ускорения обучения, настройки и вывода крупных моделей с более чем 10 миллиардами параметров. Присоединяйтесь к нашему сообществу с открытым исходным кодом и сделайте большие модели доступными для всех.

-

Воспользуйтесь мощным ИИ для автономных задач с LongCat-Flash. MoE LLM с открытым исходным кодом предлагает непревзойдённую производительность и экономичный, сверхбыстрый вывод.

-

Откройте для себя StableLM — открытую языковую модель от Stability AI. Генерируйте высокопроизводительный текст и код на персональных устройствах с помощью небольших и эффективных моделей. Прозрачная, доступная и поддерживаемая технология ИИ для разработчиков и исследователей.

-

Qwen2.5-Turbo от Alibaba Cloud. Контекстное окно в 1 миллион токенов. Быстрее и дешевле конкурентов. Идеально подходит для исследований, разработки и бизнеса. Резюмирует статьи, анализирует документы. Позволяет создавать передовой conversational AI.

-

Языковые модели серии Qwen2.5 предлагают расширенные возможности благодаря более крупным наборам данных, большему объему знаний, улучшенным навыкам программирования и математики, а также более тесному соответствию человеческим предпочтениям. Открытый исходный код и доступны через API.

-

JetMoE-8B был обучен с затратами менее 0,1 миллиона долларов1, но превосходит LLaMA2-7B от Meta AI, которая имеет многомиллиардные ресурсы обучения. Обучение LLM может быть намного дешевле, чем обычно считается.

-

Jina ColBERT v2 поддерживает 89 языков с превосходной производительностью поиска, управляемыми пользователем размерностями вывода и длиной токена 8192.

-

GPT-NeoX-20B — это крупная авторегрессивная языковая модель с 20 миллиардами параметров, обученная на Pile с использованием библиотеки GPT-NeoX.